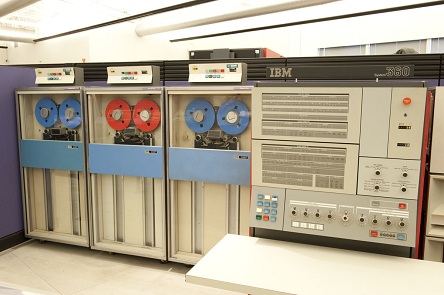

A mediados de los 60 del siglo pasado muchas grandes empresas adoptaron la decisión de instalar un ‘mainframe’, es decir, una computadora como ‘núcleo central’ de sus servicios de gestión y control, tanto económicos como administrativos y comerciales. El anuncio por IBM de la salida al mercado de su serie 360, en abril de 1964, fue el catalizador de estas decisiones. Antes ya existían equipos definidos como computadoras y más tarde ordenadores, pero eran de propósito científico y utilizados básicamente en el ámbito de la investigación, en la universidad, o en el campo estadístico. Su utilización fuera de éstos era mínima.

El citado anuncio, seguido por otras marcas americanas y europeas, desencadenó la carrera en la gran empresa y en la Administración para dotarse, en muchos casos sin saber muy bien para qué, de uno de estos ‘núcleos de proceso de datos’ (así se siguen llamando en algunos casos) y de almacenamiento de la información económico-financiera. Su potencia y sus capacidades eran despreciables de acuerdo con la óptica y medida de hoy, pero su concepto, su arquitectura y sus capacidades de conexión con elementos periféricos de almacenamiento y de entrada/salida, era ya poderosa. Su uso permitió empezar a resolver las funciones básicas de la administración de las empresas (nóminas, contabilidad, gestión financiera, control de ventas, etc.…); también hizo posible los primeros intentos de gestión de almacenes y control de stocks.

El software de base, empezando por el propio sistema operativo que muy pronto permitió compartir múltiples tareas y usuarios, los programas de utilidad o servicio y los lenguajes de programación denominados comerciales (fundamentalmente el Ensamblador y el Cobol), permitieron programar aplicaciones a medida de las necesidades de cada empresa y vislumbrar claramente ‘en casa propia’ la capacidad de estas tecnologías para ayudar a la gestión y control de una manera mucho más eficaz que los métodos antes usados basados, en el mejor de los casos, en equipos de registro unitario cuando no en elaboración manual.

Cada empresa tenía su filosofía de uso de estas nuevas herramientas. Además su actividad de negocio determinaba en gran medida su incipiente aplicación. Si en las empresas comerciales el reto era la gestión de stocks, la cartera de clientes y el control del crédito en sus diversas modalidades, en las bancarias era la gestión de las cuentas y depósitos de empresas y particulares y en las industrias el control de producción. Hay que decir que pronto surgieron ‘paquetes’ que pretendían resolver, o al menos ayudar a la solución, estos problemas. Muchos eran diseñados y comercializados por los propios fabricantes del hardware pero otros ya eran ajenos, lo que dio origen a la venta de software y servicios por parte de terceros.

La entrada masiva de datos era un obstáculo común; siempre fue fuente de errores y discrepancias, que afectaban a la propia fiabilidad de los datos resultantes. Los sistemas directos de captación, primero en ficha perforada de ardua elaboración y manejo y, más tarde, los ‘data entry’ en cinta eran lentos y costosos y exigían procesos farragosos de verificación y cuadre manual no sólo de cada dato sino del conjunto de ellos. Además los equipos necesarios para ello estaban muy concentrados y físicamente casi unidos a los locales en que se albergaba el mainframe. Era frecuente la existencia de procesos y de sistemas duplicados para asegurar la calidad del dato y la reiteración de tareas, a efectos de cuadre, era inevitable. La integración de resultados y los cuadros de mando para la gestión eran, en el mejor de los casos, procesos realimentados de la información procedente de otras aplicaciones o extraídos manualmente de ellas, lo que generaba nuevos riesgos de error.

La aparición del teleproceso, a través de redes privadas basadas en líneas punto a punto suministradas por el operador de voz existente entonces en nuestro país, con protocolos específicos de comunicación para datos también suministrados por el fabricante del mainframe, permitió descentralizar esta entrada de datos, llevándola en gran medida al lugar donde se generaban los mismos. El teleproceso no sólo permitió la conexión al mainframe de pantallas de propósito general en todo tipo de grandes compañías, sino también un gran número de terminales y de periferia especializada para resolver problemáticas propias de cada sector de actividad. Fue una gran revolución en el comercio, en la banca y en la industria.

Si nos centramos en un caso concreto que me es muy familiar, el Comercio, la aparición a mitad de los años 70 de terminales específicos cara al cliente (‘terminales punto de venta’ que sustituyeron a las tradicionales ‘cajas registradoras’), ¡conectados en red de bucle a un servidor! y la conexión tanto de este como de terminales o pantallas al mainframe, para consolidar y gestionar todas las operaciones y los datos derivados de ellas, permitió una gestión integrada de la información, desde la puramente comercial referida al punto de venta a la necesaria para la reposición de mercancía desde el almacén o desde el proveedor, pasando por los aspectos contables, financieros, fiscales y retributivos. Esta visión de la información como flujo, lo que hoy conocemos como ‘gestión integrada’ o, en el acrónimo anglosajón, ERP, obligaba entre otras cosas a una centralización y control de la misma, evitando las dobles entradas y los cuadres manuales y proporcionando seguridad y fiabilidad absoluta en el circuito. De esta forma, la entrada directa de datos, vía perforación o grabación, se redujo al mínimo y se puede afirmar que el mainframe alcanzó su madurez conceptual y operativa de uso en el Comercio. Lo mismo ocurrió en la banca con los terminales de ventanilla y sobre todo con la aparición de los cajeros automáticos.