Índice de temas

Años 70

Uno de los programas más destacados de los primeros años de la IA fue SHRDLU. Fue desarrollado por Terry Winograd como tesis doctoral bajo la supervisión de Marvin Minsky y pretendía hacer avanzar la conversación entre el hombre y la máquina. Los temas de conversación eran muy limitados: tenían que referirse a un micromundo en el que no había más que objetos geométricos de colores, pirámides y cubos de diversos tamaños.

El humano podría ordenar al ordenador que dispusiera los objetos de forma diferente. O podría pedir información sobre la disposición de los objetos. El ordenador sabía que no se podía poner un cubo encima de una pirámide o que para mover el cubo debajo de la pirámide, primero había que deshacerse de la pirámide. En aquella época se pensaba que bastaba con añadir líneas de programación para ampliar aquel micromundo para llegar a conversar sobre Dios y el mundo con el ordenador. Esta idea resultó ser errónea.

Cuando el matemático británico James Lighthill elaboró un informe sobre las perspectivas de la investigación en IA para el gobierno británico a principios de la década de 1970, llegó a un veredicto condenatorio. Esta disciplina científica no había producido nada que estuviera a la altura de las grandes expectativas que había despertado. En los círculos profesionales se dice que este informe tuvo un gran impacto, inquietando a los patrocinadores y dificultando la financiación de la investigación en IA. No obstante, el Informe Lighthill no disminuyó en nada la fama del programa Eliza (ver años 60).

A principios de la década de 1970, la IA no había producido nada que estuviera a la altura de las grandes expectativas que había despertado

Años 80

En la década de 1980, debido en gran parte a Geoffrey Hinton, el paradigma conexionista estaba en auge; junto con Geoffrey, los psicólogos estadounidenses David Rumelhart y James McClelland formaron el núcleo duro de un Grupo de Investigación sobre Procesamiento Distribuido en Paralelo (PDP). Este equipo de investigación fundó una «contrarrevolución» conexionista en los años 80 con una serie de publicaciones científicas.

El primero y más importante es algo así como la biblia del conexionismo: «Parallel Distributed Processing: Explorations in the Microstructure of Cognition”, una obra de dos tomos y más de 1.000 páginas, publicada en 1987. En ella, los investigadores del PDP Research Group lograron demostrar que, contrariamente a las previsiones de Minsky y Papert, las grandes redes neuronales multicapa con mecanismos para la retroalimentación de errores sí son capaces de resolver tareas difíciles en el campo del reconocimiento de patrones.

Muchos avances en el campo del aprendizaje profundo se basan en la técnica de memoria desarrollada por Jürg Schmidhuber y su estudiante de doctorado Sepp Hochreiter en Suiza; se denomina “Long short-term memory” y permite a las redes neuronales multicapa retener el contenido correcto del aprendizaje.

Otra innovación en el campo de las redes neuronales profundas (Deep Neuronal Networks) es la retro-propagación de errores, que Hinton y Rummelhart presentaron en la revista científica «Nature» en 1987. Más tarde se supo que el informático finlandés Seppo Linnainmaa había llegado a las mismas conclusiones en los años setenta, pero que en aquella época no encontró a nadie que se interesara por sus hallazgos.

Años 90

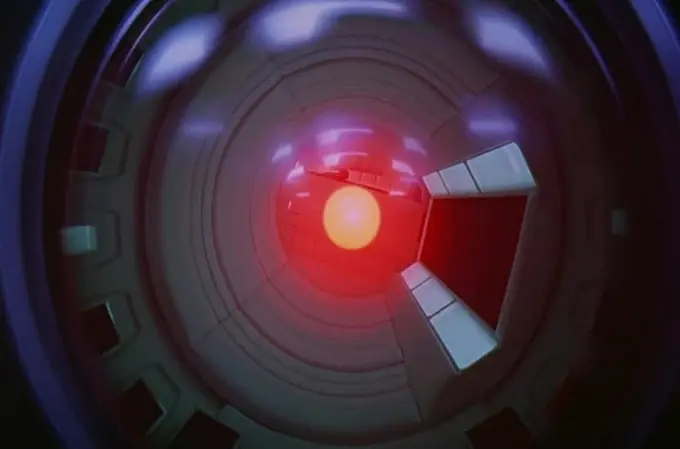

El 12 de enero de 1992, en los laboratorios HAL de la localidad estadounidense de Urbana (Illinois), se concibió un ordenador capaz de rivalizar en inteligencia con los humanos. Este ordenador solo existía sobre el papel; no era más que el producto de la imaginación, inventado décadas antes por el autor de ciencia ficción Arthur C. Clarke. Más que todos los otros ordenadores (reales) y programas de IA, y muy por encima de todas las discusiones científicas y análisis periodísticos de ciencia, HAL ha logrado impregnar una imagen duradera de IA en la mente colectiva.

El 12 de enero de 1992, en los laboratorios HAL de la localidad estadounidense de Urbana (Illinois), se concibió un ordenador capaz de rivalizar en inteligencia con los humanos

Por su nombre completo, HAL 9000 cuenta con una inteligencia similar a la humana, entiende el lenguaje, incluso puede leer los labios. Junto al actor Keir Dullea, HAL 9000 es el principal protagonista en la película, estrenada en 1968, ‘2001: Una odisea del espacio’ de Stanley Kubrick. En la película, HAL está convencido de que puede cumplir mejor los objetivos de la misión sin humanos mientras vuela por el espacio. Después de que el ordenador haya matado a varios astronautas, el último humano superviviente consigue destruir el ordenador megalómano, a sabiendas de que no van a poder sobrevivir sin su ayuda.

En 1997, Garri Kasparov perdió dos partidas contra el ordenador de ajedrez ‘Deep Blue‘, construido por ingenieros de IBM. Era la primera vez que un campeón mundial de ajedrez tuvo que admitir su derrota ante un ordenador. Esta máquina brillaba sobre todo por sus capacidades de tipo A: equipado con sus 480 procesadores especiales, podía calcular hasta 200 millones de posiciones de ajedrez por segundo. Kasparov pidió la revancha en vano. Poco después de su publicitada actuación, ‘Deep Blue’ fue desguazado.

2012

Alphazero no es simplemente una mejor versión de ‘Deep Blue’. Este software de IBM representa un programa de investigación cuyo objetivo es describir la inteligencia con la ayuda de reglas lógicas: el paradigma se denomina IA simbólica y probablemente alcanzó su cenit con Deep Blue. Alphazero (igual Alphago) se basa en métodos de aprendizaje profundo (Deep Learning, o DL) para reconocer las jugadas exitosas de un gran número de partidas. Casi todos los avances recientes en IA utilizan métodos de aprendizaje profundo.

«El aprendizaje profundo ha ayudado mucho en la resolución de problemas que se habían resistido durante años, a pesar de los mejores esfuerzos de los investigadores de IA», escribió Geoffrey Hinton en 2015 en un ensayo muy leído en la revista científica Nature.

El Deep Learning ha alcanzado su cenit y el futuro de la IA pasa por la unión de los paradigmas simbólico y conexionista

Este texto marca un punto de inflexión, un cambio de paradigma. Sin embargo, no se puede decir que el aprendizaje profundo (DL) haya sustituido a la IA simbólica como sucesora. De hecho, el planteamiento DL es anterior al enfoque de la IA simbólica, pero su desarrollo se impidió por muchas intrigas desagradables durante décadas. Existe una escuela de investigadores de IA muy reputados que sostiene que el DL ha alcanzado su cenit y que el futuro de la IA pasa por la unión de los paradigmas simbólico y conexionista.

Geoffrey Hinton enseña ahora en la Universidad de Toronto. También dirige la investigación sobre IA en Google. Se ha distinguido como investigador de IA con innovaciones en el campo del reconocimiento de imágenes, por ejemplo; junto con investigadores de Google, IBM y Microsoft también logró grandes avances en el campo del reconocimiento de voz. Tras varios años de ausencia y debido a estos notables logros, la IA vuelve a formar parte del debate público.

2017

En 2017, Deepmind, con sede en Londres, dio a conocer un programa de ajedrez que podía enseñarse a sí mismo a jugar al ajedrez en cuestión de horas y luego vencer a los mejores ajedrecistas o programas de ajedrez. Deepmind, que fue adquirida por Google en 2014, se hizo famosa con un software llamado Alphago. En el juego de mesa Go, derrotó al mejor jugador del mundo en 2016. La primera versión de este software aprendió el juego reproduciendo partidas jugadas por humanos.

Hoy en día hay muchos programas de ajedrez -Stockfish, Houdini, Komodo, Fritz, Deep Shredder y otros- capaces de enfrentarse con un campeón del mundo de ajedrez. Pero las partidas de exhibición entre el hombre y la máquina han perdido su atractivo y hoy lo más interesante es la competición entre máquinas. Aquí, Deepmind Alphazero se impuso hace un año, superando claramente al mejor programa de ajedrez: Stockfish.

Es notable que los programas de ajedrez actuales jueguen mejor que Deep Blue, incluso con menos potencia de cálculo. En el partido contra Alphazero, Stockfish analizó “solo” 60 millones de posiciones por segundo. Y Alphazero solo necesitó calcular sesenta mil posiciones para encontrar buenas jugadas mediante un método llamado Monte Carlo Tree Search (MCTS). Los desarrolladores de Alphazero -entre ellos el fundador de Deepmind, Demis Hassabis- escriben que se están acercando al ideal tipo B descrito por Shannon, o sea, una forma de jugar «similar a la humana».

El software Alphazero tiene sus limitaciones, escribe en Science el informático canadiense Murray Campbell, que trabaja para IBM y participó en su día en el desarrollo de Deep Blue. El programa tiene unos requisitos de hardware muy elevados y es difícil de interpretar. No obstante, Campbell cree que con Alphazero se ha cerrado un «capítulo» de la historia de la inteligencia artificial y se ha puesto fin a un proyecto de «varias décadas». Los investigadores de IA tendrán que buscar nuevos retos.

2018

Una encuesta de expertos publicada en 2018 considera que las máquinas avanzan por la vía rápida: se espera que tareas como escribir una redacción escolar, traducir textos, transcribir el lenguaje hablado o doblar la ropa podrán ser realizadas mejor o más barato por máquinas durante la década actual.

La mayoría de los 352 expertos encuestados esperaban que el avance de la inteligencia artificial de alto nivel se daría a mediados de siglo

Antes de que las máquinas se impongan en todos los ámbitos y superen a los humanos como músicos, novelistas o cirujanos, por ejemplo, aún faltaría tiempo: la mayoría de los 352 expertos encuestados esperaban que el avance de la inteligencia artificial de alto nivel se daría a mediados de siglo. La encuesta fue realizada por el Future of Humanity Institute de la prestigiosa Universidad de Oxford. Lo destacable de este estudio es que, de los expertos participantes en la encuesta, casi todos creen que el progreso se está acelerando en su campo. Esto significaría que nos acercamos al objetivo de una «superinteligencia» a una velocidad cada vez mayor.

Hoy

Los avances en la investigación de la IA se escenifican a menudo como un partido de exhibición entre el hombre y la máquina: el actor estadounidense Keir Dullea en el papel del astronauta contra Hal 9000, Garry Kasparov contra Deep Blue, Lee Sedol contra Alphago. Estos partidos de exhibición tienen un gran impacto mediático, sobre todo cuando gana la máquina; es cuando se cuestiona la posición del hombre como cúlmine de la creación. Sin embargo, es muy difícil evaluar de forma realista las capacidades de las máquinas. Las empresas que desarrollan IA no tienen ningún interés en informar de sus fracasos. Por eso se podría decir que el auge actual de la IA también se basa un poco en la exageración.

Lo que hace falta es «inteligencia colaborativa», las máquinas deben aprender a incluir a la contraparte humana en la búsqueda de soluciones

El más reciente desarrollo basado en IA, ChatGPT, junto a Bard y otras aplicaciones para la edición de imágenes, etc., permite a cualquiera interactuar directamente y, por tanto, ha avivado de nuevo el debate público sobre la IA. Si es cierto que ChatGPT viene con algunos fallos, no debemos subestimar su capacidad para aprender de los errores. Los expertos coinciden en que la IA transformadora es una tendencia que se acelera y es probable que la colaboración entre los humanos y la máquina sea la clave para una transición exitosa.

O sea, si la IA quiere hacerse útil en la vida cotidiana de las personas, debe aprender a trabajar en equipo. Lo que hace falta es «inteligencia colaborativa«. Las máquinas deben aprender a incluir a la contraparte humana en la búsqueda de soluciones, deben aprender a cuestionarse a sí mismas, a hacer frente a las incertidumbres, a improvisar. No sólo tendrán que aportar soluciones, sino también formas de encontrar soluciones y no sólo respuestas, sino también preguntas.